Ce vendredi 11 mars, nous avons envoyé notre contribution à la consultation publique de la Commission nationale de l’informatique et des libertés (CNIL) portant sur le projet de position de l’organisme à propos des caméras dites « intelligentes » ou « augmentées » dans les espaces public.

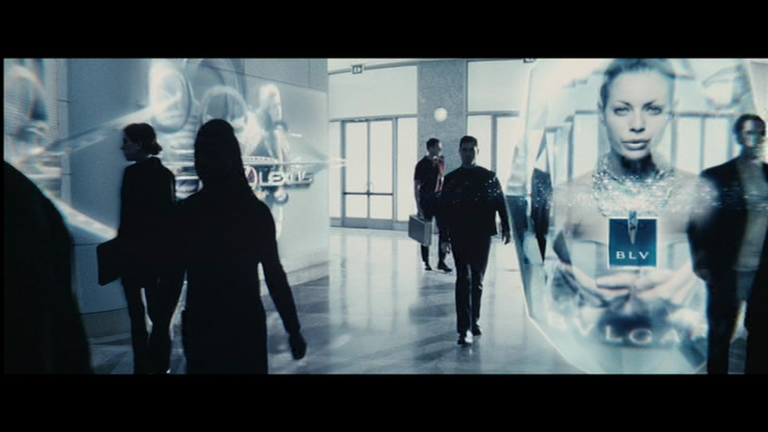

Ces caméras comprennent les dispositifs qui captent l’audience à des fins publicitaires. Si le projet de position de la CNIL propose quelques lignes rouges pour ces capteurs d’audience1, il ouvre néanmoins la possibilité à leur utilisation sans possibilités pour les personnes étudiées de refuser de participer à ces études grandeur nature au seul bénéfice du secteur publicitaire.

Retrouvez ci-dessous notre contribution.

Contribution de Résistance à l’Agression Publicitaire

Consultation caméra « intelligentes » de la CNIL

11 mars 2022

Remarques préliminaires et générales

Il nous semble important de mettre en lumière le danger que représente la collecte des données à des fins publicitaires. En effet, elles sont utilisées majoritairement pour cibler la publicité ou d’autres messages à caractère commercial ou politique. Ces données sont revendues. C’est pourquoi il est indispensable de ne pas se limiter à l’anonymisation des données. Cette anonymisation permet certes la protection de la vie privée à l’échelle individuelle, mais ces données n’empêchent pas les manipulations de masse que permettent leur analyse statistique. Il nous semble en cela pertinent d’envisager les conséquences sociales au titre de la protection de la liberté d’opinion et de la protection de la vie privée dans une approche collective.

Avis partie 1

Comme le disent les chercheur·ses en communication Antoinette Rouvroy et Thomas Berns, « Sans considérer [les législations sur la vie privée] comme vain[es], nous voulons signaler ici avec force l’indifférence de ce « gouvernement algorithmique » pour les individus, dès lors qu’il se contente de s’intéresser et de contrôler notre « double statistique », c’est-à-dire des croisements de corrélations, produits de manière automatisée, et sur la base de quantités massives de données, elles-mêmes constituées ou récoltées « par défaut ». »2

Leurs recherches, comme beaucoup d’autres, montrent les effets très dangereux sur la santé mentale et la démocratie de ces technologies. En déduisant de nos données nos opinions, nos manières de consommer, de nous déplacer, etc., les entreprises et États contournent notre expression personnelle, nous empêchent de dire ce que nous voulons, ce que nous pensons, ce que nous sommes. Des décisions politiques sont prises sur la base de préférences déduites de ces données massives, sans que jamais personne ne soit consulté. Or le processus de subjectivation est primordial dans la formation d’une opinion, il permet des discussions communes, une auto-critique, et donc un progrès vers des opinions plus rationnelles, qui prennent en compte plus d’intérêts que le sien propre. Une « mentalité élargie » selon la formule d’Hannah Arendt.

Il nous semble important aussi de placer comme ligne rouge un contournement du principe de consentement univoque. Nous défendons le principe de liberté de réception pour les publicités, c’est-à-dire que recevoir de la publicité doit être l’effet d’une démarche active. Nous voulons donc inverser la logique : au lieu de supposer le consentement des personnes et de leur demander d’effectuer une démarche active pour sortir du dispositif (opt-out), nous portons l’idée inverse : par défaut, les personnes ne consentent pas aux dispositifs. Si elles veulent en faire partie, il faut pour cela qu’elle effectuent une démarche active (opt-in) en s’inscrivant, d’une manière simple et ergonomique.

Cette disposition permet d’éviter les écueils actuels, qui sont une extorsion de consentement par des contrats très complexes, des conditions générales que personne ne lit, et des procédures d’opt-out parfois complexes ou absurdes. Par exemple, certains dispositifs de collecte des données de smartphone dans l’espace public demandent, pour exprimer son non-consentement, de se placer pendant 10 secondes dans une zone, ou d’aller inscrire l’adresse MAC de son smartphone sur un site internet. Dans les deux cas, ces procédures sont coûteuses en temps, et dans le deuxième cas, nécessitent des connaissances techniques que n’ont pas la majorité des personnes. Par défaut la vidéosurveillance automatisée nous semble devoir présumer du consentement et en cela le bafouer complètement.

Avis partie 2

Sur cette partie, nous ne commentons que le paragraphe 2.2.7 qui dit : « Une appréciation globale de ces dispositifs n’a pas de sens : il convient de les appréhender au cas par cas, en fonction en particulier des risques qu’ils comportent pour les intéressés. »

Nous pensons qu’il faut au contraire poser ces lignes rouges qui ensuite s’appliquent au cas particulier. C’est le principe du droit.

Le problème du cas par cas, c’est que les entreprises ou États iront trop vite pour que le droit s’adapte, comme le montrent les travaux de Bernard Stiegler sur la disruption. Il faut créer maintenant un cadre limitant, et, si certaines applications ont besoin d’élargir ce cadre, alors à ce moment nous pourrons étudier cette éventualité. La logique inverse nous semble dangereuse car les entreprises privées ou publiques profiteront de ce vide juridique pour installer des dispositifs ne respectant ni l’éthique ni le droit. C’est ce que font actuellement les GAFAM, qui sous la pression populaire et législative effectuent des micro-reculs, mais ont installé beaucoup de dispositifs qui violent les données personnelles et l’éthique.

Avis partie 4

De manière plus précise, et pour les raisons évoquées dans nos remarques préliminaires nous nous opposons avec force au régime dérogatoire qui est proposé pour les « traitements de données à des fins statistiques ».

Nous voyons bien que la notion de délai introduite par la CNIL est une protection pour les individus contre l’influence exercée par la publicité, mais nous la trouvons bien faible.

L’exemple pris par l’avis (un panneau publicitaire qui récolte des données pour mieux cibler ses publicités) pour justifier cet avis est judicieux et très parlant. Mais le ciblage publicitaire n’est pas une manière éthique d’adapter la publicité aux personnes. C’est plutôt une tentative de les influencer de la manière la plus efficace, en contournant leur rationalité3. Reprendre cette dialectique de l’adaptation du service aux personnes sans la critiquer, c’est se ranger du côté du secteur publicitaire qui agrège des quantités gigantesques de données pour mieux cibler ses publicités, et ainsi augmenter le prix des espaces publicitaires.

De plus, la production de données à des fins statistiques s’assimile à une recherche impliquant la personne humaine. Ces recherches demandent le consentement préalable, libre, éclairé, univoque et exprès des participant·es. Il paraît étonnant que des études dont l’intérêt légitime semble peu contestable soient soumises à des contraintes plus fortes que pour le traitement de données à des fins publicitaires, dont on peine à saisir l’intérêt légitime qui permettrait de se passer du consentement des personnes étudiées, majoritairement à leur insu.

Pour les raisons évoquées dans la partie 1, nous pensons aussi que les mesures d’opt-out préconisées par cet avis sont insuffisantes. Nous défendons une absence de consentement par défaut et une démarche active des personnes qui voudront signifier leur consentement à l’agrégation de leurs données.

En effet, comme le souligne le projet de position, « les dispositifs vidéo captent automatiquement l’image des personnes passant dans leur spectre de balayage et la traitent souvent instantanément, sans possibilité d’éviter les personnes ayant exprimé préalablement leur opposition ou d’interrompre le traitement. En pratique, ces personnes pourront uniquement obtenir la suppression de leurs données, lorsqu’elles auront été conservées, et non éviter leur traitement. »

Permettre l’exclusion du droit d’opposition pour les dispositifs qui ne feraient « que » des analyses statistiques sans utilisation en temps réel transformerait les espaces publics et privés où ces dispositifs seraient implantés en laboratoire géant dont nous serions les cobayes non consentants, au seul profit du secteur publicitaire, dont, encore une fois, l’intérêt légitime paraît contestable.

Nous voyons bien les problèmes posés selon les dispositifs (par exemple les caméras de surveillance qui voudraient suivre des personnes contrevenant à la loi dans la ville), mais comme la partie 1 de cet avis le précisait, ces nouveaux dispositifs « posent des questions éthiques et juridiques nouvelles » (1.7). Ces dispositifs ne nous semblent ni désirables, ni véritablement utile et peuvent poser de lourds problèmes sociaux et il paraît pertinent de les abandonner et de faire arrêter ceux déjà installés ou expérimentés pour les présenter comme acquis avant qu’ils ne le soient vraiment.

L’idée d’analyser les données en local, et de ne pas les transmettre aux entreprises, nous semble une bonne chose pour les raisons évoquées plus haut. Le problème sera celui du contrôle. Comment vérifier que les données ne sont pas récoltées dans un second temps et revendues à des « data brokers« , puis utilisées plus tard à des fins de surveillance ou de ciblage publicitaire ? Cela poserait pourtant les mêmes problèmes que la récolte statistique immédiate.

—

Notes

1 « La CNIL estime ainsi que ne pourraient en principe pas reposer sur l’intérêt légitime :

– des dispositifs qui analysent et segmentent les personnes, sur la base de critères tels que l’âge ou le genre afin de leur adresser des publicités ciblées ;

– des dispositifs qui analysent et segmentent les personnes sur la base de leurs émotions ou de données sensibles (santé, religion, orientation sexuelle, etc.) ;

– des dispositifs qui analysent le comportement et les émotions des personnes sur la base de la détection de leurs gestes et expressions, ou de leurs interactions avec un objet ;

A défaut de reposer sur une autre base légale, telle que le consentement des personnes, ces dispositifs n’apparaissent pas pouvoir être légalement mis en œuvre »

2 In ROUVROY Antoinette, BERNS Thomas, « Gouvernementalité algorithmique et perspectives d’émancipation. Le disparate comme condition d’individuation par la relation ? », Réseaux, 2013/1 (n° 177), p. 163-196 https://www.cairn.info/revue-reseaux-2013-1-page-163.htm#no4

3 Nous vous renvoyons pour plus de détails à notre analyse de la manipulation publicitaire et ses conséquences : https://blogs.mediapart.fr/resistance-agression-pub/blog/231121/publicite-lindustrialisation-de-la-manipulation

Votre don est notre force

Votre don est notre force